L'intelligence artificielle a parcouru un long chemin depuis R2-D2. De nos jours, la plupart des millénaires seraient perdus sans systèmes GPS intelligents. Des robots naviguent déjà sur les champs de bataille et des drones pourraient bientôt livrer des colis Amazon à nos portes.

Siri peut résoudre des équations complexes et vous dire comment faire cuire du riz. Elle a même prouvé qu'elle pouvait même répondre aux questions avec un sens de l'humour.

Mais toutes ces avancées dépendent du fait que l'utilisateur donne la direction de l'IA. Que se passerait-il si les unités GPS décidaient de ne pas aller chez le teinturier, ou pire encore, Siri décidait qu'elle pourrait devenir plus intelligente sans vous?

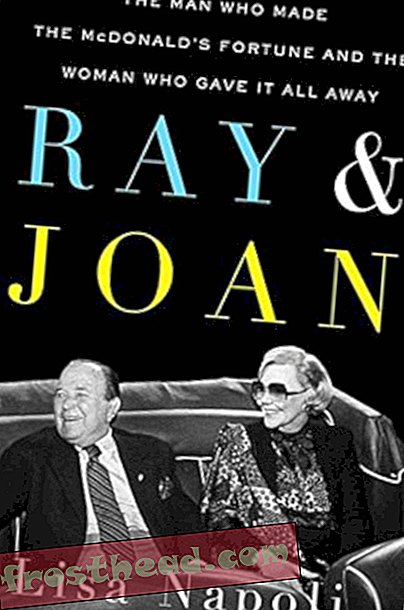

Notre dernière invention: l'intelligence artificielle et la fin de l'ère humaine. "> Notre dernière invention: l'intelligence artificielle et la fin de l'ère humaine. ">" Avant de partager la planète avec des machines super-intelligentes, nous devons développer une science pour les comprendre. Sinon, ils prendront le contrôle ", déclare l'auteur James Barrat à propos de son nouveau livre, Notre dernière invention: l'intelligence artificielle et la fin de l'ère humaine . (Avec la permission de James Barrat)

Notre dernière invention: l'intelligence artificielle et la fin de l'ère humaine. ">" Avant de partager la planète avec des machines super-intelligentes, nous devons développer une science pour les comprendre. Sinon, ils prendront le contrôle ", déclare l'auteur James Barrat à propos de son nouveau livre, Notre dernière invention: l'intelligence artificielle et la fin de l'ère humaine . (Avec la permission de James Barrat) James Barrat, auteur et documentariste, prédit dans son nouveau livre, Notre dernière invention: l'intelligence artificielle et la fin de l'ère humaine .

Selon Barrat, l'intelligence artificielle - de Siri aux drones en passant par les systèmes d'exploration de données - cessera bientôt de demander aux humains de se moderniser et de rechercher elle-même des améliorations. Et contrairement aux R2-D2 et aux HAL de la science-fiction, l'IA de notre avenir ne sera pas nécessairement amicale, dit-il: ils pourraient en réalité être ce qui nous détruit.

En un mot, pouvez-vous expliquer votre grande idée?

Au cours de ce siècle, les scientifiques créeront des machines avec une intelligence égale et supérieure à la nôtre. Mais avant de partager la planète avec des machines super-intelligentes, nous devons développer une science pour les comprendre. Sinon, ils prendront le contrôle. Et non, ce n'est pas de la science fiction.

Les scientifiques ont déjà créé des machines qui sont meilleures que les humains aux échecs, Jeopardy!, navigation, exploration de données, recherche, démonstration de théorèmes et d'innombrables autres tâches. Finalement, des machines seront meilleures que les humains lors de la recherche sur l'IA

À ce stade, ils pourront améliorer très rapidement leurs propres capacités. Ces machines auto-améliorées poursuivront les objectifs avec lesquels elles ont été créées, qu’il s’agisse d’exploration spatiale, de jouer aux échecs ou de ramasser des actions. Pour réussir, ils rechercheront et dépenseront des ressources, qu’il s’agisse d’énergie ou d’argent. Ils chercheront à éviter les modes de défaillance, comme être éteint ou débranché. En bref, ils vont développer des lecteurs, y compris l'auto-protection et l'acquisition de ressources, des lecteurs très similaires aux nôtres. Ils n'hésiteront pas à mendier, emprunter, voler et pire encore pour obtenir ce dont ils ont besoin.

Comment êtes-vous devenu intéressé par ce sujet?

Je suis un documentariste. En 2000, j’ai interviewé l’inventeur Ray Kurzweil, le robotique Rodney Brooks et la légende de la science-fiction Arthur C. Clarke pour un film sur la fabrication du roman et du film 2001: Une odyssée de l’espace. Les entretiens ont exploré l’idée du Hal 9000 et d’ordinateurs malveillants. Les livres de Kurzweil décrivent l'avenir de l'IA comme une «singularité» ravissante, une période au cours de laquelle les progrès technologiques dépassent la capacité des humains à les comprendre. Pourtant, il ne prévoyait que de bonnes choses, issues de l'IA, suffisamment fortes pour égaler puis surpasser l'intelligence humaine. Il prédit que nous pourrons reprogrammer les cellules de notre corps afin de vaincre la maladie et le vieillissement. Nous allons développer une super endurance avec des nanobots qui fournissent plus d'oxygène que les globules rouges. Nous allons surcharger notre cerveau avec des implants informatiques afin de devenir super-intelligents. Et nous porterons nos cerveaux sur un support plus durable que notre actuel «wetware» et vivrons éternellement si nous le souhaitons. Brooks était optimiste, insistant sur le fait que les robots améliorés par l'intelligence artificielle seraient des alliés et non des menaces.

Le scientifique devenu auteur, Clarke, en revanche, était pessimiste. Il m'a dit que l'intelligence l'emporterait et que les humains se disputeraient probablement la survie avec des machines ultra-intelligentes. Il n'était pas précis sur ce qui se passerait lorsque nous partagerions la planète avec des machines super intelligentes, mais il estimait que ce serait une lutte pour l'humanité que nous ne gagnerions pas.

Cela allant à l'encontre de tout ce que j'avais pensé à l'IA, j'ai donc interrogé des experts en intelligence artificielle.

Quelles preuves avez-vous pour soutenir votre idée?

L'intelligence artificielle avancée est une technologie à double usage, comme la fission nucléaire, capable de causer un très grand bien ou un grand préjudice. Nous commençons à peine à voir le mal.

Le scandale de la confidentialité de la NSA est dû au fait que la NSA a développé des outils d'extraction de données très sophistiqués. L’agence a utilisé son pouvoir pour analyser les métadonnées de millions d’appels téléphoniques et de l’ensemble de l’Internet - de manière critique, tous les courriers électroniques. Séduit par le pouvoir de l'IA pour l'exploration de données, un organisme chargé de protéger la Constitution en a plutôt abusé. Ils ont développé des outils trop puissants pour pouvoir les utiliser de manière responsable.

Aujourd'hui, une autre bataille éthique se prépare pour la fabrication de drones tueurs entièrement autonomes et de robots de champ de bataille alimentés par une intelligence artificielle avancée - des tueurs humains sans êtres humains en attente. Cela se prépare entre le ministère de la Défense et les fabricants de drones et de robots rémunérés par le DOD, ainsi que des personnes qui pensent qu'il est imprudent et immoral de créer des machines à tuer intelligentes. Les partisans des drones autonomes et des robots du champ de bataille affirment qu'ils seront plus moraux, c'est-à-dire moins émotionnels, cibleront mieux et seront plus disciplinés que les opérateurs humains. Ceux qui s'opposent au fait que les humains ne soient pas pris au dépourvu se penchent sur la misérable histoire de drones consistant à tuer des civils et sur leur implication dans des assassinats extrajudiciaires. Qui supporte la culpabilité morale quand un robot tue? Les fabricants de robots, les utilisateurs de robots ou personne? Peu importe l’obstacle technique de dissuader un ami de l’ennemi.

À plus long terme, comme le soutiennent les experts de mon livre , l'intelligence artificielle approchant du renseignement humain ne sera pas facilement contrôlée; malheureusement, la super-intelligence n'implique pas la bienveillance. Comme le théoricien de l'intelligence artificielle Eliezer Yudkowsky de MIRI [l'Institut de recherche sur l'intelligence artificielle] le dit, "l'IA ne vous aime pas, elle ne vous déteste pas, mais vous êtes composée d'atomes qu'elle peut utiliser pour autre chose." Si nous construisons une machine, nous allons créer des psychopathes super intelligents, des créatures sans compas moral et nous ne serons pas leurs maîtres très longtemps.

Qu'y a-t-il de nouveau dans votre pensée?

Des individus et des groupes aussi divers que l'informaticien américain Bill Joy et MIRI ont longtemps averti que nous avions beaucoup à craindre des machines dont l'intelligence éclipsait la nôtre. Dans notre dernière invention, je soutiens que l'intelligence artificielle sera également mal utilisée dans le processus de développement de l'intelligence humaine. Entre aujourd'hui et le jour où les scientifiques créent une intelligence au niveau humain, nous aurons des erreurs liées à l'IA et des applications criminelles.

Pourquoi n’en at-on pas fait plus, ou que fait-on pour empêcher l’intelligence artificielle de nous attaquer?

Il n'y a pas une seule raison, mais plusieurs. Certains experts ne pensent pas que nous sommes suffisamment proches pour créer une intelligence artificielle au niveau humain et au-delà pour nous inquiéter de ses risques. De nombreux fabricants d'IA décrochent des contrats avec la DARPA (Défense pour les projets de recherche avancée) et ne veulent pas soulever de problèmes qu'ils considèrent politiques. Le biais de normalité est un biais cognitif qui empêche les gens de réagir aux catastrophes et aux catastrophes qui se préparent - cela en fait définitivement partie. Mais beaucoup de fabricants d'IA font quelque chose. Découvrez les scientifiques qui conseillent MIRI. Et beaucoup plus seront impliqués une fois que les dangers d'une intelligence artificielle avancée entreront dans le dialogue traditionnel.

Pouvez-vous décrire un moment où vous avez su que c'était grand?

Nous, les humains, guidons l'avenir non pas parce que nous sommes les créatures les plus rapides ou les plus puissantes de la planète, mais parce que nous sommes les plus intelligents. Lorsque nous partageons la planète avec des créatures plus intelligentes que nous, elles orienteront l'avenir. Quand j'ai compris cette idée, j'ai eu l'impression d'écrire sur la question la plus importante de notre époque.

Chaque grand penseur a des prédécesseurs dont le travail a été déterminant pour sa découverte. Qui vous a donné les bases pour construire votre idée?

Les fondements de l'analyse des risques liés à l'IA ont été développés par le mathématicien IJ Good, l'écrivain de science-fiction Vernor Vinge, et d'autres, dont le développeur d'IA, Steve Omohundro. Aujourd'hui, MIRI et le Future of Humanity Institute d'Oxford sont presque les seuls à s'attaquer à ce problème. Notre dernière invention comprend environ 30 pages de notes de fin de document reconnaissant ces penseurs.

Dans la recherche et le développement de votre idée, quel a été le point culminant? Et le point bas?

Les points culminants ont été l’écriture de notre dernière invention et mon dialogue permanent avec les décideurs et les théoriciens de l’IA. Les personnes qui programment l'IA connaissent les problèmes de sécurité et souhaitent contribuer à la mise en place de mesures de protection. Par exemple, MIRI travaille à créer une IA «conviviale»

L'informaticien et théoricien Steve Omohundro a préconisé une approche «d'échafaudage», dans laquelle une intelligence artificielle manifestement sûre aide à construire la prochaine génération d'IA pour assurer sa sécurité. Ensuite, l'IA fait de même et ainsi de suite. Je pense qu'un partenariat public-privé doit être créé pour réunir les fabricants d'IA dans le but de partager des idées sur la sécurité, comme l'Agence internationale de l'énergie atomique, mais en partenariat avec des entreprises. Les points bas? Réalisant que la technologie la plus avancée et la plus avancée en matière d'IA sera utilisée pour créer des armes. Et ces armes finiront par se retourner contre nous.

Quelles sont les deux ou trois personnes les plus susceptibles d'essayer de réfuter votre argument? Pourquoi?

L'inventeur Ray Kurzweil est l'apologiste en chef des technologies de pointe. Dans mes deux entretiens avec lui, il a affirmé que nous allions fusionner avec les technologies de l'IA grâce à des améliorations cognitives. Kurzweil et des personnes généralement appelées transhumanistes et singularitaires pensent que l'intelligence artificielle et, finalement, l'intelligence générale artificielle et au-delà vont évoluer avec nous. Par exemple, les implants informatiques vont améliorer la vitesse et les capacités globales de notre cerveau. Finalement, nous développerons la technologie pour transférer notre intelligence et notre conscience dans des ordinateurs. Ensuite, la super-intelligence sera au moins en partie humaine, ce qui, en théorie, garantirait que la super-intelligence soit «en sécurité».

Pour de nombreuses raisons, je ne suis pas fan de ce point de vue. Le problème, c’est que nous, les humains, n’avons pas une sécurité suffisante, et il semble peu probable que des êtres humains super intelligents le soient aussi. Nous n'avons aucune idée de ce qu'il advient de l'éthique humaine après le renforcement de son intelligence. Nous avons une base biologique pour l'agression qui manque aux machines. La super-intelligence pourrait très bien être un multiplicateur d'agression.

Qui sera le plus touché par cette idée?

Tout le monde sur la planète a beaucoup à craindre du développement non réglementé de machines super intelligentes. Une course au renseignement se déroule actuellement. Réaliser AGI est la tâche numéro un de Google, d'IBM et de nombreuses petites entreprises telles que Vicarious and Deep Thought, ainsi que de la DARPA, de la NSA, ainsi que des gouvernements et des entreprises à l'étranger. Le profit est la principale motivation de cette course. Imaginez un objectif probable: un cerveau humain virtuel au prix d'un ordinateur. Ce serait le produit le plus lucratif de l'histoire. Imaginez des banques de milliers de cerveaux de doctorat travaillant 24h / 24, 7j / 7 sur le développement pharmaceutique, la recherche sur le cancer, le développement d'armes et bien plus encore. Qui ne voudrait pas acheter cette technologie?

Dans le même temps, 56 pays développent des robots sur le champ de bataille et la volonté est de les rendre autonomes, ainsi que leurs drones. Ce seront des machines qui tuent, sans surveillance humaine. Ce sont les drones autonomes et les robots du champ de bataille qui blesseront le plus les pays pauvres. Initialement, seuls les pays riches pourront se permettre de tuer des robots autonomes, de sorte que les pays riches utiliseront ces armes contre des soldats humains appartenant à des pays pauvres.

Comment cela pourrait-il changer la vie telle que nous la connaissons?

Imaginez: en une décennie à peine, une demi-douzaine d'entreprises et de pays utilisent des ordinateurs qui rivalisent ou surpassent l'intelligence humaine. Imaginez ce qui se passe lorsque ces ordinateurs deviennent des experts en programmation d'ordinateurs intelligents. Bientôt, nous partagerons la planète avec des machines des milliers, voire des millions de fois plus intelligentes que nous. Et, pendant ce temps, chaque génération de cette technologie sera militarisée. Non réglementé, ce sera catastrophique.

Quelles questions sont laissées sans réponse?

Solutions. La solution évidente serait de donner aux machines un sens moral qui leur donne de la valeur pour la vie et la propriété humaines. Mais programmer une éthique dans une machine s'avère extrêmement difficile. Les normes morales diffèrent d'une culture à l'autre, elles changent avec le temps et sont contextuelles. Si nous, humains, n'arrivons pas à nous mettre d'accord sur le début de la vie, comment pouvons-nous dire à une machine de protéger la vie? Voulons-nous vraiment être en sécurité ou voulons-nous vraiment être libres ? Nous pouvons en débattre toute la journée et ne pas parvenir à un consensus, alors comment pouvons-nous éventuellement le programmer?

Comme je l’ai dit plus tôt, nous devons également réunir les développeurs d’IA. Dans les années 1970, des chercheurs en ADN recombinant ont décidé de suspendre leurs recherches et de se réunir pour une conférence à Asilomar, à Pacific Grove, en Californie. Ils ont mis au point des protocoles de sécurité élémentaires du type «ne traquez pas l'ADN sur vos chaussures», de peur de contaminer l'environnement par des travaux génétiques en cours. Grâce aux «lignes directrices Asilomar», les cultures génétiquement modifiées bénéficient au monde et la thérapie génique semble prometteuse. À notre connaissance, les accidents ont été évités. Il est temps pour une conférence Asilomar pour AI

Qu'est-ce qui fait obstacle?

Un vent économique énorme propulse le développement de l'intelligence artificielle avancée L'intelligence au niveau humain au prix d'un ordinateur sera le produit le plus en vogue de l'histoire. Google et IBM ne voudront pas partager leurs secrets avec le public ou leurs concurrents. Le ministère de la Défense ne voudra pas ouvrir ses laboratoires en Chine et en Israël, et inversement. La sensibilisation du public doit pousser les politiques vers l'ouverture et les partenariats public-privé visant à assurer la sécurité.

Quelle est la prochaine pour vous?

Je suis un documentariste, alors bien sûr, je pense à une version cinématographique de Notre dernière invention .