Le visage humain est alimenté, selon la façon dont vous les comptez, entre 23 et 43 muscles, dont beaucoup s'attachent à la peau, ne servant aucune fonction évidente de survie. Un étranger examinant un spécimen humain seul ne saurait pas quoi en faire. Tirant sur le front, les sourcils, les lèvres et les joues, les muscles transmettent une mine d'informations sur notre état émotionnel, notre niveau d'intérêt et notre vigilance. C’est un moyen de communication remarquablement efficace, presque instantané, généralement précis, qui transcende la plupart des barrières linguistiques et culturelles. Mais parfois, les données sont perdues, ignorées ou mal interprétées. Si un bûcheron souriait dans la forêt sans que personne ne puisse le voir, était-il vraiment heureux?

De cette histoire

[×] FERMER

Tellement longtemps les émoticônes. Le scientifique développe une technologie capable de détecter et de lire nos expressions

Vidéo: Smithsonian Ingenuity Awards 2015: Rana el Kaliouby

Lectures connexes

Intelligence émotionnelle: Pourquoi ça peut compter plus que le QI

AcheterRana el Kaliouby n'aime pas que cette information soit perdue. En rencontrant el Kaliouby dans son petit bureau à Waltham, dans le Massachusetts, je la vois contracter son gros muscle zygomatique, soulevant les coins de sa bouche, et son orbicularis oculi, froissant les coins extérieurs de ses yeux. Elle est souriante et je déduis qu'elle m'accueille avant même d'avoir entendu le mot «bonjour». Mais de nombreux échanges sociaux se déroulent aujourd'hui sans interaction face à face en temps réel. C'est là qu'El Kaliouby et sa compagnie entrent en scène.

El Kaliouby, qui a 37 ans, sourit souvent. Elle a un visage rond, agréable et expressif et une attitude empreinte de sollicitude, ce qui la conforte dans sa position de cofondatrice d'une start-up en pleine croissance, un anti-Bezos et un non-Zuckerberg. Son entreprise, Affectiva, qu'elle a fondée en 2009 avec une collègue de l'époque au MIT Media Lab, Rosalind Picard, occupe une position à la pointe de la technologie en matière d'utilisation des ordinateurs pour détecter et interpréter les expressions faciales humaines. Ce domaine, appelé «informatique affective», vise à combler le fossé de la communication entre les êtres humains et les machines en ajoutant un nouveau mode d’interaction, notamment le langage non verbal des sourires, des sourires et des sourcils. «La prémisse de ce que nous faisons est que les émotions sont importantes», déclare El Kaliouby. «Les émotions ne perturbent pas notre pensée rationnelle, mais la guident et l'informent. Mais ils sont absents de notre expérience numérique. Votre smartphone sait qui vous êtes et où vous êtes, mais il ne sait pas ce que vous ressentez. Nous visons à résoudre ce problème. "

Pourquoi votre smartphone a-t-il besoin de savoir comment vous vous sentez? El Kaliouby a une foule de réponses, toutes fondées sur l'intégration apparemment illimitée des ordinateurs dans les routines de notre vie quotidienne. Elle envisage «une technologie permettant de contrôler l'éclairage, la température et la musique dans nos maisons en réponse à nos humeurs» ou des applications permettant d'adapter le contenu d'un film en fonction de vos réactions inconscientes pendant que vous regardez. Elle imagine des programmes capables de surveiller votre expression lorsque vous conduisez et d'avertir de l'inattention, de la somnolence ou de la colère. Elle sourit à la mention de son idée favorite: «un réfrigérateur qui détecte votre stress et verrouille la crème glacée».

Elle pense en particulier qu'Affectiva et la technologie qu'il contribue à introduire dans le grand public seront une aubaine pour les soins de santé. Un chercheur qui teste un nouveau médicament, ou un thérapeute traitant un patient, reçoit des informations uniquement de temps en temps, sous réserve de tous les problèmes d'autodéclaration - désir inconscient de plaire au médecin, par exemple, ou rappel sélectif favorisant les souvenirs les plus récents. . El Kaliouby envisage un programme fonctionnant en arrière-plan sur l'ordinateur portable ou le téléphone du sujet, qui pourrait compiler un enregistrement instantané de son humeur au cours d'une période donnée (une journée, un mois) et le corréler avec le le temps ou tout ce que votre appareil peut mesurer ou suivre. «Cela ne devrait même pas faire partie d'un programme de traitement», pense-t-elle. "Vous pouvez simplement l'avoir sur votre téléphone et il vous dit que chaque fois que le" X "appelle, vous avez une expression négative, ce qui vous dit quelque chose que vous ne saviez peut-être pas."

Abonnez-vous au magazine Smithsonian pour seulement 12 $

Cette histoire est une sélection du numéro de décembre du magazine Smithsonian.

AcheterEl Kaliouby préconise l'informatique affective comme prochaine étape logique de la progression du clavier à la souris en passant par l'écran tactile et la reconnaissance vocale. Au printemps, Affectiva a publié son premier kit de développement de logiciel commercial, que les développeurs, intéressés par les états émotionnels en temps réel des utilisateurs, peuvent intégrer à leurs propres programmes - lecteurs de musique ou applications de jeu ou de rencontres, par exemple. Et juste cet automne, Affectiva a lancé Emotion As a Service, un programme basé sur le cloud dans lequel les clients peuvent télécharger des vidéos pour les analyser. Qui pourrait l'utiliser? Un candidat sur le point d'être interviewé pour un travail qui s'inquiète de paraître anxieux ou ennuyé ou même de sourire. Ou encore une compagnie aérienne qui embauche des agents de bord avec des centaines d'applications vidéo à la recherche de ceux qui peuvent gérer un sourire convaincant en faisant leurs adieux aux passagers. (Un sourire sincère, qui implique une contraction des muscles aux coins des yeux, est appelé sourire «Duchenne», du nom de l'anatomiste du 19ème siècle; son contraire, un sourire forcé qui utilise seulement la bouche, est parfois parfois appelé «sourire panaméricain».)

Et, bien sûr, les appareils exécutant ce logiciel sont tous connectés à Internet, de sorte que les informations recueillies sont instantanément rassemblées, triées et mises en réseau de la même manière que les applications de médias sociaux identifient des sujets ou des personnalités populaires. Peut-être compilé dans quelque chose comme un indice d'humeur Affectiva, une lecture numérique du bonheur national brut, ou ventilé dans des régions où les sourires ou les sourcils froncent actuellement.

Le programme de base d’Affectiva analyse le visage 20 fois par seconde à la recherche de 46 expressions localisées de bonheur, de tristesse, de surprise, de peur, de colère, de dégoût et de mépris, ainsi que d’intérêt et de confusion. (Naomi Shavin / Smithsonian)

Le programme de base d’Affectiva analyse le visage 20 fois par seconde à la recherche de 46 expressions localisées de bonheur, de tristesse, de surprise, de peur, de colère, de dégoût et de mépris, ainsi que d’intérêt et de confusion. (Naomi Shavin / Smithsonian) Jusqu'à présent, les principaux clients d'Affectiva étaient des sociétés de publicité, de marketing et de médias. Son logiciel automatise le processus de gestion d'un groupe de discussion, le rituel fastidieux de rassembler une douzaine de personnes dans une salle afin de donner leur avis sur un nouveau produit, une série télévisée ou une campagne publicitaire. il enregistre les réactions directement, sans qu'un participant ait à tordre un cadran ou à répondre à un questionnaire en réponse à une présentation. De plus, le logiciel élargit le groupe de discussion potentiel au monde entier, ou du moins à la fraction substantielle de celui-ci, qui dispose d'un ordinateur ou d'un appareil mobile avec webcam.

Les commentaires de l'œil acharné et voyant de Affectiva ont contribué à façonner une sitcom télévisée en réseau, renvoyant deux personnages à l'oubli pour le péché de ne pas faire sourire les téléspectateurs. (El Kaliouby n'identifiera ni la série ni les personnages.) Son logiciel a été utilisé pour créer un «échantillonneur de sourire», une machine qui distribue des friandises aux clients qui sourient à sa caméra. Avec davantage de recherches, il pourrait probablement être utile pour la surveillance de la foule dans les aéroports, pour identifier les éventuels voleurs à l'étalage ou comme détecteur de mensonge.

Mais el Kaliouby a résisté à ces applications subreptices, aussi lucratives soient-elles. Elle pense que l'informatique affective changera le monde, notamment en vendant des tablettes de chocolat. «La philosophie de notre société consiste à utiliser cette technologie pour améliorer la vie des gens et les aider à mieux communiquer, pas seulement pour aider les annonceurs à vendre plus de produits.

**********

Contrairement à de nombreux entrepreneurs technologiques, s’enrichir ne figurait pas à l’ordre du jour initial d’el Kaliouby. Née au Caire de parents égyptiens qui travaillent dans la technologie, elle a étudié l'informatique à l'université américaine du Caire, où elle a obtenu son diplôme en 1998, à l'époque où les ordinateurs devenaient assez puissants pour que les chercheurs pensent à les doter de ce qui est humainement. appelé l'intelligence émotionnelle.

Elle a poursuivi ses études en informatique à l'Université de Cambridge et est arrivée juste après les attaques du 11 septembre 2001 contre l'Amérique. Ses parents pensaient qu'elle risquait d'être arrêtée, harcelée ou pire en raison de son héritage. Mais bien qu'elle ait porté une coiffe musulmane jusqu'à il y a quelques années, ni à Cambridge en Angleterre ni à Cambridge dans le Massachusetts, où elle a déménagé en 2006 pour rejoindre le MIT Media Lab, ne se préoccupait jamais de sa religion ou de son apparence. . «Je pense que c'est parce que je souris beaucoup», dit-elle en souriant.

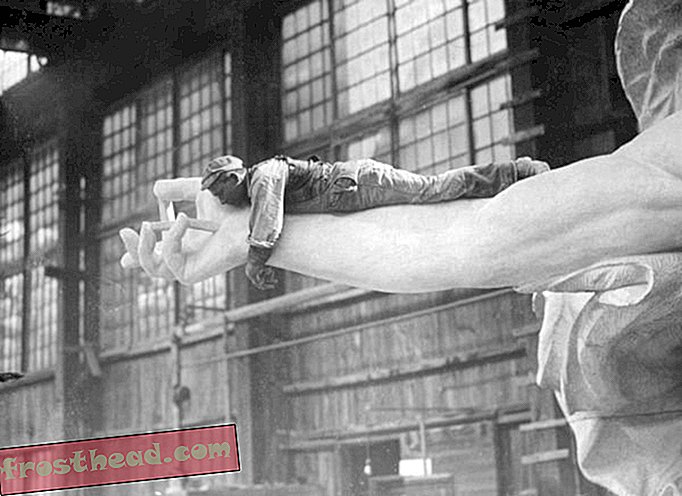

L'anatomiste français Duchenne a publié des études marquantes sur les expressions faciales humaines. (Images Bridgeman)

L'anatomiste français Duchenne a publié des études marquantes sur les expressions faciales humaines. (Images Bridgeman) À Cambridge, elle s’intéressait au problème de l’autisme, en particulier aux difficultés qu’éprouvaient les enfants autistes à lire les expressions faciales. Elle a proposé de construire un «appareil auditif émotionnel» pouvant être utilisé pour lire les visages et indiquer les comportements appropriés à l'utilisateur. Rejetée au début par une subvention de la National Science Foundation au motif que le projet était trop difficile, elle et ses collègues ont construit un prototype consistant en une paire de lunettes munie d'un minuscule appareil photo, de lumières clignotantes et d'un casque. une première version de Google Glass. Une deuxième demande de subvention a été acceptée et, après son déménagement au MIT, elle et son équipe ont travaillé pendant trois ans pour la perfectionner et la tester dans une école de Rhode Island. El Kaliouby le décrit comme «un projet de recherche et un succès» - les enfants autistes qui l'ont utilisé ont eu des expériences extrêmement positives - mais en 2008, à la fin de la subvention, elle a dû faire face à un moment de compte. L'intérêt commercial pour l'informatique affective grandissait et elle souhaitait qu'elle se développe et prospère. mettre ses efforts dans le développement des lunettes limiterait celle-ci à une infime partie de ses utilisations potentielles. Ainsi, avec Picard, elle s'est séparée d'Affectiva, tout en espérant qu'une autre société prendrait l'aide auditive émotionnelle et la commercialiserait.

Lors de la création d’Affectiva, les quelques «membres de l’équipe» qui composaient l’entreprise ont chacun choisi une valeur qu’ils souhaitaient incarner, comme «apprentissage», «responsabilité sociale» ou «divertissement». À lui, en tant que responsable des stratégies et des sciences, C'était «de la passion». Cette entreprise de 20 personnes est gérée comme une quasi-démocratie, avec des réunions semestrielles au cours desquelles les employés votent sur les priorités à poursuivre au cours des six prochains mois. Son bureau a un tableau blanc recouvert de dessins de la jeune fille d'un de ses collègues; elle a un fils de 6 ans, Adam, et une fille de 12 ans, Jana, qui vit avec elle dans la banlieue de Boston (leur père vit en Égypte). Son comportement est doux et attentionné; une heure dans une réunion du matin, elle propose de commander un sandwich pour une visiteuse, même si elle saute elle-même son déjeuner. "C'est le Ramadan pour moi", dit-elle en souriant, "mais ce n'est pas le Ramadan pour vous."

Elle place les visiteurs à un bureau, face à un moniteur et à une webcam. le logiciel localise le visage du visiteur et dessine un cadre autour de celui-ci à l'écran. Il identifie un ensemble de points à suivre: les coins des yeux et de la bouche, le bout du nez, etc. Vingt fois par seconde, le logiciel recherche des «unités d’action», le jeu souvent fugace des muscles du visage. Selon le système de classification standard, le système de codage des actions faciales (FACS), il en existe 46. Ils comprennent des élévateurs de sourcils intérieurs et extérieurs, des dimplers, des clignements d'oeil, des clins d'œil et des fronces, des entonnoirs, des presseurs et des nuls. Le programme standard d’Affectiva en échantillonne environ 15 à tout moment et les analyse pour dégager sept émotions de base: bonheur, tristesse, surprise, peur, colère, dégoût et mépris, plus intérêt et confusion. Souriez, et vous pouvez voir la mesure du bonheur monter en flèche; Bouclez vos lèvres dans un ricanement et le programme note votre dégoût.

Ou, plus précisément, votre expression de dégoût. Le principe même de l'informatique affective repose sur ce qui équivaut à un acte de foi, à savoir qu'un sourire véhicule un sentiment de bonheur, de plaisir ou d'amusement. Bien sûr, les êtres humains sont dans la même position: on peut se laisser berner par un faux sourire ou une colère feinte, de sorte qu'on ne peut pas vraiment en attendre plus d'un programme informatique, du moins pas encore.

Au fil du temps, Affectiva a constitué une archive de plus de trois millions de vidéos de visages téléchargées par des utilisateurs Internet recrutés dans quelque 75 pays du monde. Des centaines de milliers d'entre eux ont été analysés par des observateurs qualifiés et codés pour des unités d'action FACS, une entreprise monumentale, car les vidéos durent en moyenne 45 secondes et prennent chacune environ cinq fois plus de temps. Les résultats des codeurs humains ont à leur tour été utilisés pour «entraîner» les algorithmes de la société, qui traitaient le reste en temps réel. L'ensemble de la base de données comprend maintenant environ 40 milliards de «points de données d'émotion», une ressource qui fait la fierté d'Affectiva par rapport à d'autres sociétés du même domaine, comme Emotient, en Californie, probablement son concurrent le plus proche.

(Graphique: Infographie 5W; Source: Daniel McDuff, MIT Media Lab, Affectiva)

(Graphique: Infographie 5W; Source: Daniel McDuff, MIT Media Lab, Affectiva) Daniel McDuff, qui a rejoint Affectiva au MIT Media Lab et est directeur de la recherche, étudie en permanence cet atout pour approfondir ses connaissances sur l'expression des émotions. Comment diffèrent-ils selon l'âge, le sexe et la culture? (Peut-être étonnamment, McDuff a découvert que les personnes âgées sont plus expressives que les plus jeunes, en particulier vis-à-vis des émotions positives.) Pouvons-nous mesurer de manière fiable le mépris, la gêne, l’ennui, l’anxiété? Quand un sourcil sur un sillon indique-t-il une confusion et quand indique-t-il une concentration? Comment pouvons-nous distinguer entre une expression de peur et une qui signifie surprise? (Indice: l'unité d'action 1, le «leveur de sourcils intérieur», est le marqueur de la peur; l'unité d'action 2, le «leveur de sourcils externe» indique la surprise.) Il y a, dit-il, toutes les raisons de croire que le programme se poursuivra pour mieux détecter les expressions (même si cela ne peut jamais complètement surmonter le plus grand obstacle: le Botox).

À ma demande, McDuff a donné à l'émission l'un des grands problèmes classiques de détection d'émotion, la Mona Lisa, dont l'énigmatique quasi-sourire intrigue les téléspectateurs depuis 500 ans. Mentionnant toutefois que le logiciel fonctionne mieux avec des expressions changeantes et non avec des images statiques, il n’a trouvé aucune trace d’un sourire sincère de La Gioconda, mais plutôt une combinaison des unités d’action 28 (rouleau pour les lèvres) et 24 (lèvres serrées)., suggérant peut-être un certain niveau d'inconfort.

**********

«Je vous parle maintenant, dit El Kaliouby, et je vous surveille pour mesurer votre intérêt pour ce que je dis. Devrais-je ralentir et expliquer plus? Devrais-je passer à un autre sujet? Maintenant, imaginez que je donne un webinaire à un grand groupe que je ne peux ni voir ni entendre. Je n'ai aucun retour, il n'y a aucun moyen de savoir si une blague a fonctionné ou est tombée à plat, si les gens sont fiancés ou ennuyés. Ne serait-il pas formidable d’obtenir ces commentaires en temps réel, sous forme agrégée, d’un moment à l’autre? "

Elle joue une publicité pour Jibo, un "robot social" disponible en pré-commande sur le site de financement participatif Indiegogo et développé par une ancienne collègue du MIT, Cynthia Breazeal. Jibo est assis sur une table et scrute son environnement. Il identifie les personnes vis-à-vis de leurs visages et interagit avec elles - relayant des messages, émettant des rappels, effectuant des appels téléphoniques routiniers, voire même bavardant. Ceci est une autre application potentielle du logiciel d’Affectiva - les entreprises sont en pourparlers - et c’est «une perspective très excitante», déclare el Kaliouby.

Excitant pour certains, mais la perspective de robots de traitement des émotions est alarmante pour d’autres. Sherry Turkle, qui a longtemps étudié le rapport des humains aux ordinateurs, met en garde dans son nouveau livre, Reclaiming Conversation: Le pouvoir de la conversation à l'ère numérique, à propos du «moment robotique», lorsque les machines commencent à se substituer à la compagnie. Turkle pense que des scientifiques comme El Kaliouby et son équipe peuvent faire ce qu’ils prétendent. «Ce sont toutes des personnes brillantes et douées qui accomplissent un travail remarquable», dit-elle. Et elle convient que dans certains contextes (environnements dangereux, tels que l’espace ou autour de machines lourdes, dans lesquels vous souhaitez utiliser tous les modes de communication possibles), l’informatique affective a un rôle à jouer. «Mais la prochaine étape, dit-elle, ne suit pas du tout. La prochaine étape est, faisons un ami robot. J'ai interviewé des parents qui sont heureux que leurs enfants parlent à Siri, et je pense que cela ne nous mène pas sur une route où nous voulons aller. Nous nous définissons comme des êtres humains par ceux auxquels nous nous associons, et cela n’a aucun sens pour moi de former votre estime de soi par rapport à une machine. Pourquoi voudriez-vous qu'un ordinateur sache si vous êtes triste?

Même El Kaliouby a tendance à accepter que «nous passons plus de temps que nous le devrions avec nos appareils», en pensant bien entendu à sa fille de pré-adolescente, dont le regard se verrouille sur l'écran de son smartphone.

Mais elle considère que la tendance à la connectivité toujours plus grande est irréversible et elle pense que, même si les utilisateurs devraient toujours avoir leur mot à dire, nous pourrions également en tirer le meilleur parti. Elle prédit que nos appareils auront «une puce d'émotion et une suite d'applications qui l'utilisent d'une manière qui ajoute suffisamment de valeur à nos vies pour compenser les préoccupations des utilisateurs en partageant ces données». Elle établit une analogie avec les appareils GPS: l'informatique tactile peut Aidez-nous à naviguer dans l'espace émotionnel de la même manière que les applications téléphoniques nous aident à nous déplacer dans un espace physique. «Tout le monde s’inquiétait des dispositifs de détection de position lors de leur première sortie: ils envahissaient notre vie privée, ils nous suivaient tout le temps», dit-elle. «Seulement maintenant, nous serions tous perdus sans Google Maps sur nos téléphones. Je pense que ce sera la même chose.

**********