![]()

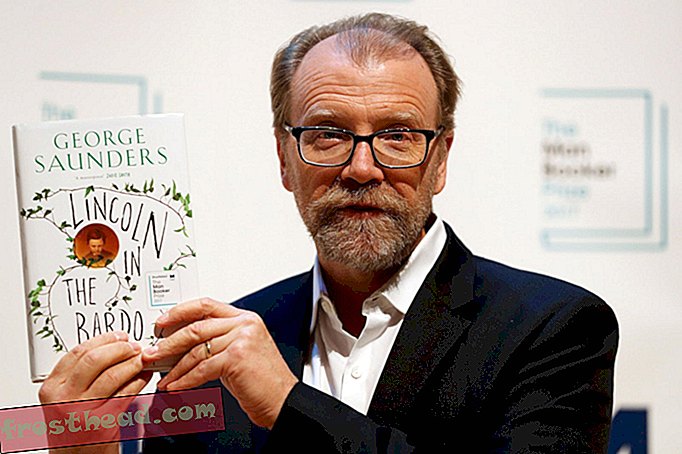

Reconnaissance des motifs d'une aile de papillon. Image fournie par Li Li

Ici à Washington, nous avons entendu parler de ce que vous appelez «planification préalable», mais nous ne sommes pas encore prêts à l'accepter. Un peu trop futuriste.

Néanmoins, nous ne pouvons nous empêcher d’admirer de loin ceux qui tentent de prédire ce qui pourrait se passer dans plus d’un mois. J'ai donc été impressionné il y a quelques semaines lorsque les grands penseurs d'IBM ont imaginé le monde dans cinq ans et ont identifié ce qu'ils pensent être cinq domaines d'innovation qui auront le plus grand impact sur notre vie quotidienne.

Ils le font depuis quelques années maintenant, mais cette fois-ci, les sifflements confus ont suivi un thème: les cinq sens humains. Non pas qu'ils disent qu'avant 2018, nous serons tous capables de voir, d'entendre et de sentir mieux, mais plutôt les machines: en utilisant des technologies sensorielles et cognitives en évolution rapide, les ordinateurs accéléreront leur transformation à partir de la récupération de données et traitement des moteurs à des outils de réflexion.

Voir un motif?

Aujourd'hui, abordons la vision. Il est logique de supposer qu'IBM fait peut-être référence au Project Glass de Google. Il ne fait aucun doute que le rôle des lunettes a été redéfini, allant de l'accessoire geek qui nous aide à mieux voir au combo smartphone / périphérique de plongée que nous porterons un jour sur nos visages.

Mais ce n’est pas ce dont parlent les IBMers. Ils se concentrent sur la vision artificielle, en particulier sur la reconnaissance des formes, grâce à laquelle les ordinateurs sont en mesure d’identifier des objets grâce à une exposition répétée aux images.

Il s’est avéré que Google s’est impliqué dans l’une des expériences les plus remarquables de reconnaissance de modèles de l’année dernière, un projet dans lequel un réseau de 1 000 ordinateurs utilisant 16 000 processeurs permettait, après avoir examiné 10 millions d’images de vidéos YouTube, de s’apprendre à chat ressemblait.

Ce qui est particulièrement impressionnant, c’est que les ordinateurs ont pu le faire sans aucune indication humaine sur ce qu’il faut rechercher. Tous les apprentissages ont été réalisés grâce aux machines travaillant ensemble pour décider quelles caractéristiques des chats méritaient leur attention et quels modèles étaient importants.

Et c'est le modèle de la vision des machines. Voici comment John Smith, cadre supérieur chez Intelligent Information Management d’IBM, l’explique:

«Disons que nous voulions enseigner à un ordinateur à quoi ressemble une plage. Nous commençons par montrer à l'ordinateur de nombreux exemples de scènes de plage. L'ordinateur transforme ces images en caractéristiques distinctes, telles que la répartition des couleurs, les motifs de texture, les informations sur les contours ou les informations de mouvement dans le cas d'une vidéo. Ensuite, l'ordinateur commencerait à apprendre à distinguer les scènes de plage des autres scènes en fonction de ces différentes caractéristiques. Par exemple, il apprendrait que pour une scène de plage, certaines distributions de couleurs sont généralement trouvées, par rapport à un paysage urbain du centre-ville. "

Comment est intelligent est intelligent?

Bien pour eux. Mais admettons-le, l’identification d’une plage est une chose assez fondamentale pour la plupart d’entre nous, êtres humains. Pourrions-nous nous laisser emporter par le nombre de machines pensantes capables de faire pour nous?

Gary Marcus, professeur de psychologie à la New York University, pense que oui. Écrivant récemment sur le site Web du New Yorker, il conclut que, si de nombreux progrès ont été accomplis dans ce que l’on appelle maintenant «l’apprentissage en profondeur», les machines ont encore beaucoup de chemin à parcourir avant d’être considérées comme réellement intelligentes.

«De manière réaliste, l'apprentissage en profondeur ne représente qu'une partie du défi plus vaste de la construction de machines intelligentes. Ces techniques manquent de moyens de représenter les relations de cause à effet (comme entre les maladies et leurs symptômes) et sont susceptibles de rencontrer des difficultés pour acquérir des idées abstraites telles que «frère / soeur» ou «identique à». Elles ne disposent pas de moyens évidents de réaliser des inférences logiques. sont encore loin d’intégrer des connaissances abstraites, telles que des informations sur ce que sont des objets, à quoi ils servent et comment ils sont typiquement utilisés. ”

Les employés d’IBM le reconnaîtront sans doute. L'apprentissage automatique se fait par étapes et non par bonds.

Mais ils pensent qu’en cinq ans, l’apprentissage en profondeur aura suffisamment progressé pour que les ordinateurs jouent, par exemple, un rôle beaucoup plus important dans le diagnostic médical, qu’ils pourraient devenir meilleurs que les médecins en ce qui concerne le dépistage des tumeurs et des caillots sanguins. ou des tissus malades en IRM, rayons X ou tomodensitométrie.

Et cela pourrait faire une grande différence dans nos vies.

Voir c'est croire

Voici d'autres façons dont la vision artificielle a un impact sur nos vies:

- Mettre votre meilleur bras en avant: la technologie développée à l'Université de Pittsburgh utilise la reconnaissance des formes pour permettre aux paraplégiques de contrôler un bras robotisé avec leur cerveau.

- Votre bouche dit oui, mais votre cerveau dit non: des chercheurs de Stanford ont découvert que l'utilisation d'algorithmes de reconnaissance de formes sur les examens IRM du cerveau pourrait les aider à déterminer si une personne souffrait réellement d'une douleur dans le bas du dos ou si elle la simulait.

- Quand vos grains de beauté sont prêts pour leurs gros plans: L'année dernière, une start-up roumaine nommée SkinVision a lancé une application iPhone permettant aux utilisateurs de prendre une photo des taupes sur leur peau, puis de demander au logiciel de reconnaissance de SkinVision d'identifier les irrégularités et d'indiquer le niveau de risque - sans offrant un diagnostic réel. La prochaine étape consiste à permettre aux personnes d'envoyer des images de leur peau directement à leur dermatologue.

- Ai-je un accord pour vous? Une technologie de marketing appelée Facedeals est en cours de développement. Cela fonctionne comme suit: une fois qu'un appareil photo situé à l'entrée d'un magasin vous reconnaît, vous recevez des offres personnalisées en magasin sur votre téléphone intelligent. Et oui, vous devez d'abord vous inscrire.

- Je le saurais n'importe où: un système informatisé de photo-identification qui utilise la reconnaissance des formes aide les scientifiques britanniques à retrouver la trace des phoques gris, qui portent des marques uniques sur leurs manteaux.

Bonus vidéo: Alors que nous parlons d'intelligence artificielle, voici un essaim de robots jouant à Beethoven, compliments des scientifiques de Georgia Tech. Je parie que vous ne vous attendiez pas à voir ça aujourd'hui.

Plus de Smithsonian.com

Un cerveau artificiel plus humain

Comment la technologie combat le terrorisme